Nuestra privacidad en la era de la inteligencia artificial: una decisión urgente

OPINIÓN Agencia de Noticias del Interior

- La inteligencia artificial ya forma parte de nuestra vida cotidiana y conoce aspectos íntimos de las personas.

- Herramientas como ChatGPT o Alexa pueden recolectar datos sensibles sin consentimiento claro.

- El caso de BetterHelp muestra los riesgos de compartir información personal con plataformas tecnológicas.

- Aceptar términos sin leer implica ceder autonomía y privacidad.

- Se alerta sobre el uso comercial de nuestros datos y la manipulación emocional.

- Se propone un uso consciente de la tecnología y medidas básicas de protección (no compartir datos sensibles, revisar configuraciones de privacidad, no reemplazar profesionales con IA).

- La defensa de la libertad y la privacidad requiere acción individual y crítica frente a estos sistemas.

La inteligencia artificial ya no es una promesa de ciencia ficción: es una presencia constante que habita nuestros dispositivos, anticipa nuestros deseos, deduce nuestros temores y reconstruye, a partir de datos, una versión inquietantemente precisa de quiénes somos. Lo hace de forma silenciosa, elegante, y muchas veces sin que lo notemos. Pero la pregunta urgente es: ¿a qué costo?

Herramientas como ChatGPT, Alexa o los algoritmos que personalizan la publicidad no solo nos "entienden", sino que nos perfilan, nos clasifican y nos venden. Nuestra ubicación, nuestras búsquedas más privadas, nuestras emociones, incluso nuestro estado de salud mental pueden ser capturados, procesados y —lo más grave— utilizados sin nuestro consentimiento informado. El escándalo de BetterHelp, que compartió datos confidenciales de pacientes con gigantes tecnológicos, es una advertencia brutal de lo que puede pasar cuando la tecnología prioriza el negocio por sobre las personas.

Cada vez que aceptamos términos y condiciones sin leer, entregamos trozos de nuestra identidad a un sistema que no fue diseñado para protegernos, sino para monetizarnos. Nos convertimos en patrones de consumo, en blancos de campañas de manipulación emocional, en objetos predecibles dentro de un mercado de datos global.

No se trata de rechazar la tecnología, sino de usarla con conciencia. De exigir límites. De educarnos para protegernos. Porque la IA no es mala en sí misma, pero mal utilizada puede ser peligrosa. Es nuestra responsabilidad romper con la pasividad digital y asumir una postura activa frente a lo que compartimos, cómo lo compartimos y con quién.

Algunas medidas simples pueden marcar la diferencia:

- No compartir información sensible con asistentes o chats automatizados.

- Revisar y ajustar configuraciones de privacidad.

- Desconfiar de respuestas que “saben demasiado”.

- Y sobre todo, no confundir estos sistemas con profesionales de salud, legales o psicológicos.

Estamos ante un punto de inflexión. O seguimos cediendo nuestra libertad pedazo a pedazo, o empezamos a actuar con criterio. Porque cada clic importa. Y cada dato cedido sin reflexión nos aleja un poco más de ser ciudadanos libres y conscientes en esta era digital.

El peronismo entra en zona de redefinición mientras el kirchnerismo se fragmenta

Empresas y ART al límite: el impacto económico del régimen de indemnizaciones bajo revisión

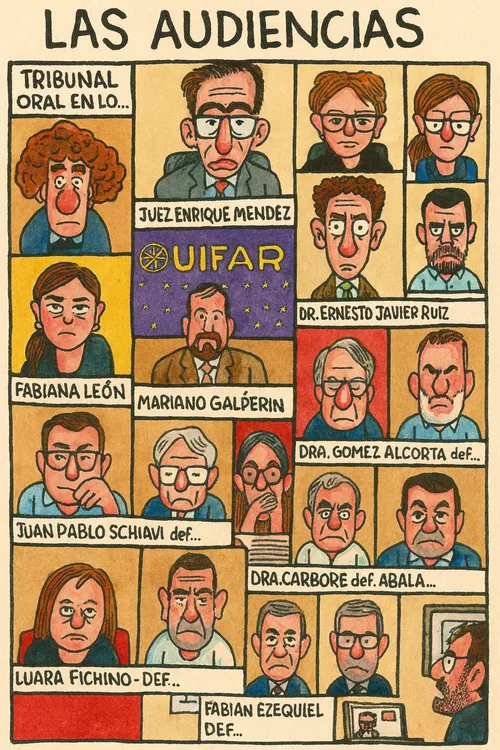

Cristina Fernández reapareció con duras críticas al plan económico y reavivó la interna kirchnerista

:quality(75):max_bytes(102400)/https://assets.iprofesional.com/assets/jpg/2024/09/583326.jpg)

Bono extraordinario y recomposición salarial: el comercio abre la temporada de fin de año con un acuerdo clave

Ajmechet endurece su perfil en Diputados y reclama “orden” en las juras mientras defiende el rumbo del Gobierno

A dos años de gestión, Milei mantiene un nivel de apoyo superior al de sus antecesores y consolida su peso político

¿Por qué Milei ninguneó a Llaryora en la presentación de los F16?